VR-Headset: mit Lichtfeldtechnik gegen Übelkeit

Professor Gordon Wetzstein und sein Team an der Stanford University haben ein VR-Headset entwickelt, das auf Lichtfeld-Technik setzt. Die soll bei Virtual-Reality-Anwendungen für einen natürlicheren 3D-Seheindruck sorgen und Übelkeit verhindern.

Der an der Stanford Computational Imaging Group entwickelte Prototyp eines VR-Headset setzt auf das von Lichtfeld-Kameras wie etwa Lytro Illum bekannte Prinzip, bei dem zusätzlich zur Intensität die Einfallrichtung des Lichts erfasst wird. Hierdurch kann ein Lichtfeld-Display auf verschiedene Bildtiefen scharf stellen ohne dass der Bildinhalt gewechselt werden muss. Für den Betrachter entfällt so der bei anderen 3D-Displays übliche Konflikt zwischen Akkomodation und Vergence, also dem Fokusebene und der Augenstellung.

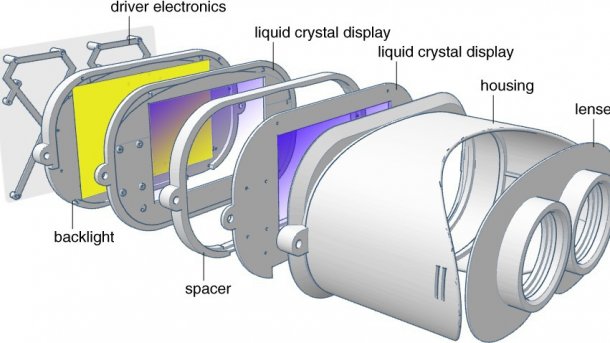

Für den Prototyp nutzte das Team LCD-Panels mit 1280 × 800er Auflösung und Vergrößerungslinsen, wie sie auch in VR-Headset wie der Rift von Oculus eingesetzt werden. Das Brillengestell druckten die Forscher mit einem Makerbot Replikator 2 selbst aus. Das zusätzliche transparente Display wurde durch einen Abstandshalter getrennt vor dem ersten Display platziert. Alles Weitere werde per Software erledigt, erklärte das Team bei der Vorstellung der Brille anlässlich der Siggraph 2015.

Durch das zusätzliche Display lassen sich zwei Bildtiefen simulieren – der Nutzer kann fließend auf den Vordergrund oder den Hintergrund der Szenerie fokussieren. Von einem echten Lichtfeld-Display mit beliebig vielen Perspektiven beziehungsweise Bildtiefen ist der Prototyp damit zwar noch weit entfernt. Er soll aber durch die nahtlose Tiefendarstellung für eine wesentlich natürlichere 3D-Darstellung sorgen. So deckt der Prototyp laut der Siggraph-Präsentation (PDF) einen Tiefenbereich von 0,2 bis 1,2 Meter ab – was sich nach wenig anhört, aber den wesentlichen Bereich umfasst, in dem der Akkomodation-Vengence-Konflikt auftritt. Die aktuelle Systemverzögerung von 65 Millisekunden erscheint dagegen zumindest für Spiele noch arg hoch.

Die Gruppe um Professor Wetzstein hat den Prototypen zusammen mit Nvidia entwickelt. Der Grafikkartenspezialist hatte bereits vor zwei Jahren auf der Siggraph ein AR-Headset vorgestellt, das die Lichtfeldtechnk nutzte. Bei echter Lichtfeld-Technik wird die sichtbare Auflösung erheblich reduziert, weil man pro Bildpunkt mehrere Pixel benötigt, um die verschiedenen Blickwinkel einzufangen. Durch ihren Ansatz mit einem zweiten Display will die Stanford-Gruppe die Auflösung etwas weniger beschneiden. Die Rechenzeit zum Rendern des Lichtfelds ist dagegen immens, was unter anderem zu der hohen Latenz führt. (uk)